- Полное прохождение

- Глава 1: Деревня Калим

- Глава 2: Гебет

- Глава 4: Казарма Стражей

- Глава 5: Святой город Аратум

- Глава 6: Осада (часть 1)

- Глава 7: Осада (часть 2)

- Глава 8: Глубинный лес

- Глава 9: Исконная кузница

- Глава 10: Забытые равнины

- Глава 11: Перелом

- Глава 12: Командный пункт Стражей

- Глава 13: Из иного мира

- Глава 14: Шпиль Нератула

- Глава 15: Город Райуул

- Глава 16: Болота КарТула

- Глава 17: Храм Ломарит

- Глава 18: Чрево зверя

- Глава 19: Пристанище душ

- Глава 20: Воскрешение

- Глава 22: Возмездие

- Все квесты и их прохождение

- Все рецепты алхимии

- Все скрытые перки

- Все загадки Вотрубы

- Карта батрака Вашека

- Карта видлакских разбойников

- Карта утопленника

- Карта Желеевских болот

- Карта лесорубов из Нижнего Семина

- Оставшаяся от мертвеца карта

- Карта слатейовских охотничьих угодий

- Карта пойманного вора

- Карта контрабандиста

- Карта Боржика

- Хижина дикой бабы

- Хижина водяного

- Перевернутая телега

- Где найти лопату?

- Как получить лошадь?

- Интерактивная карта

- Странные вирши

- Штольня под Тросками

- Два мертвых дерева

- Промокоды

- Тир-лист персонажей

- Баннеры 1.2

- Тир-лист банбу

- Инспектор Мяучело

- Памятные монеты АИК

- Пропавшие мини-грузовики

- Все скрытые квесты

- Все достижения

- Все арты c6 персонажей

- Как повысить уровень доверия агентов?

- Клякса: как приручить?

- Видеопрокат и все видеокассеты

- Отдыхающая домохозяйка: фильм

- Ностальгирующая девушка: фильм

- Влюбленная девушка: фильм

- Квест Клуб загадочников 1 и 2

- Квест Отмотай назад, детектив

- Квест Заметание секретов

- Квест Пропавшая картина

- Квест Бескрайняя бездна

- Квест Пророчество

- Квест Лимб банбу

- Все гайды

- Испытания Мерлина

- Хранилища сокровищ

- Луны мистера Муна

- Хитроумные ключи

- Головоломки Иродианы

- Квест «Призрак нашей любви»

- Квест «Колодец, колодец»

- Квест «Сокровища из проклятой гробницы»

- Квест «Гиппогриф вам укажет путь»

- Квест «Словно по звонку»

- Непростительные заклинания

- Все легендарные сундуки

- Все животные и твари

- Все метлы

- Все концовки

- Все гайды

- Башня Рамазита и колдовской погреб

- Вызов Шар — все испытания и Копье Ночи

- Логово Ансура — все чертоги и дракон

- Литейная стальной стражи — как спасти гондийцев

- Обыскать подвал — как открыть Некромантию Тхая

- Разрушенная башня — как запустить лифт

- Адамантиновая кузня — все формы и мифриловая руда

- Завершить оружейный шедевр — кора суссура

- Тетушка Этель — как спасти Майрину

- Яйцо гитьянки — как украсть и можно ли вырастить

- Мистический Падальщик — где найти слугу

- Найти клоуна Каплю — все части тела

- Как победить Геррингот Торм?

- Где найти Кровь Латандера?

- Где найти Песню Ночи?

- Все гайды

- Промокоды Honkai Star Rail

- Все сундуки Золотого мига в Honkai Star Rail

- Похвала высокой морали в Honkai Star Rail

- Все сундуки в Лофу Сяньчжоу из Honkai Star Rail

- Первооткрыватель в Honkai Star Rail

- Все сундуки Сада безмятежности в Honkai Star Rail

- Беглецы в Доме кандалов

- Заказ прокси

- Дом кандалов: сундуки и робоптахи

- Гексанексус: Remake в ХСР

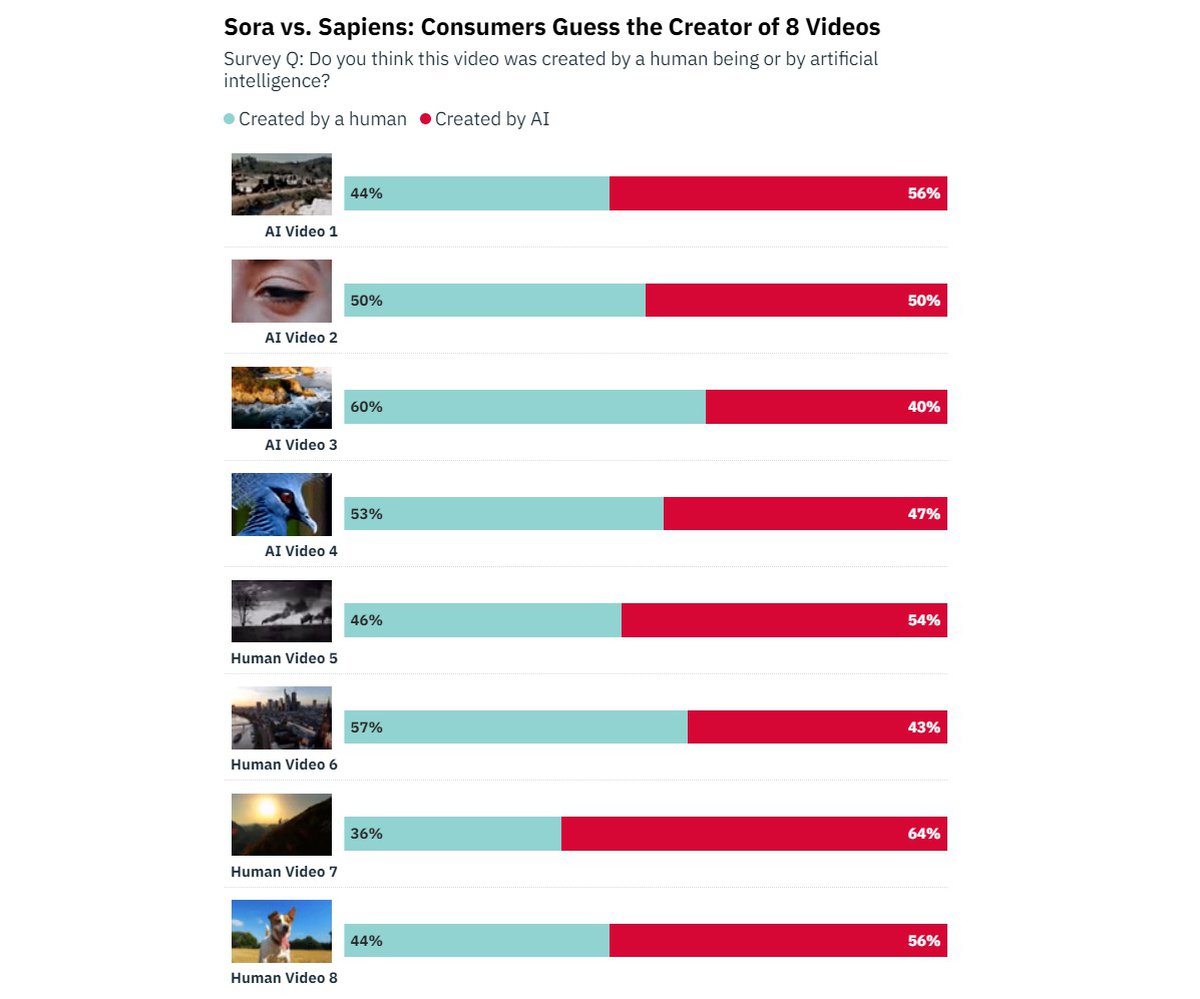

Исследование: ролики Sora от OpenAI могут обманывать людей

Но некоторые видео все-таки распознаются лучше других.

Видеоролики, создаваемые нейросетью Sora от стартапа OpenAI, способны вводить зрителей в заблуждение. К такому выводу пришли в Variety и HarrisX: компании провели исследование, в котором поучаствовало больше 1000 взрослых жителей США.

Участникам исследования показывали серию видеороликов, среди которых были как реальные видеозаписи, так и видео, созданные нейросетью. Людям предлагалось определить, где реальное видео, а где сгенерированный ролик.

Сразу несколько роликов Sora поставили участников исследования в тупик: люди считали, что они скорее реальные, чем сгенерированные. Из 8 ИИ-роликов половина признавалась реальной в 50% случаев или чаще.

Интересный момент: среди роликов Sora есть как очень удачные (признан реальным в 60% случаев), так и явно неудачные (признан нереальным в 64% случаев).

Участники исследования сочли, что необходимо законодательно регулировать создание контента с помощью ИИ. Активнее всего (74%) выступали за регулирование ИИ-роликов, лояльнее всего (61%) опрошенные отнеслись к генерации звуков.

Нейросеть Sora пока не выпущена в открытый доступ. Сейчас с ИИ могут работать только специально отобранные ученые и исследователи.

- СМИ: OpenAI и ОАЭ ведут переговоры о финансировании производства ИИ-чипов

- Генератор роликов Sora от OpenAI станет доступен всем до конца 2024 года

- В Baldur’s Gate 3 сломали Минтару: теперь она спойлерит, сидит с ребенком и не романсится

- Авторы RPCS3 показали 2 года развития эмулятора

- Сэма Альтмана снова ввели в совет директоров OpenAI

- OpenAI: Илон Маск подал в суд, потому что сожалеет о выходе из компании