- Промокоды

- Тир-лист персонажей

- Баннеры 1.2

- Тир-лист банбу

- Инспектор Мяучело

- Памятные монеты АИК

- Пропавшие мини-грузовики

- Все скрытые квесты

- Все достижения

- Все арты c6 персонажей

- Как повысить уровень доверия агентов?

- Клякса: как приручить?

- Видеопрокат и все видеокассеты

- Отдыхающая домохозяйка: фильм

- Ностальгирующая девушка: фильм

- Влюбленная девушка: фильм

- Квест Клуб загадочников 1 и 2

- Квест Отмотай назад, детектив

- Квест Заметание секретов

- Квест Пропавшая картина

- Квест Бескрайняя бездна

- Квест Пророчество

- Квест Лимб банбу

- Все гайды

- Испытания Мерлина

- Хранилища сокровищ

- Луны мистера Муна

- Хитроумные ключи

- Головоломки Иродианы

- Квест «Призрак нашей любви»

- Квест «Колодец, колодец»

- Квест «Сокровища из проклятой гробницы»

- Квест «Гиппогриф вам укажет путь»

- Квест «Словно по звонку»

- Непростительные заклинания

- Все легендарные сундуки

- Все животные и твари

- Все метлы

- Все концовки

- Все гайды

- Башня Рамазита и колдовской погреб

- Вызов Шар — все испытания и Копье Ночи

- Логово Ансура — все чертоги и дракон

- Литейная стальной стражи — как спасти гондийцев

- Обыскать подвал — как открыть Некромантию Тхая

- Разрушенная башня — как запустить лифт

- Адамантиновая кузня — все формы и мифриловая руда

- Завершить оружейный шедевр — кора суссура

- Тетушка Этель — как спасти Майрину

- Яйцо гитьянки — как украсть и можно ли вырастить

- Мистический Падальщик — где найти слугу

- Найти клоуна Каплю — все части тела

- Как победить Геррингот Торм?

- Где найти Кровь Латандера?

- Где найти Песню Ночи?

- Все гайды

- Промокоды Honkai Star Rail

- Все сундуки Золотого мига в Honkai Star Rail

- Похвала высокой морали в Honkai Star Rail

- Все сундуки в Лофу Сяньчжоу из Honkai Star Rail

- Первооткрыватель в Honkai Star Rail

- Все сундуки Сада безмятежности в Honkai Star Rail

- Беглецы в Доме кандалов

- Заказ прокси

- Дом кандалов: сундуки и робоптахи

- Гексанексус: Remake в ХСР

Нейросеть научили рисовать музыку, русский рэп она тоже может

Если повезет, то можно получить даже неразборчивый вокал.

Разработчики Сет Форсгрен и Хайк Мартирос нашли нейросети Stable Diffusion необычное применение. Вообще-то она предназначена для генерации изображение по текстовому описанию, но Сет и Хайк научили ИИ писать музыку.

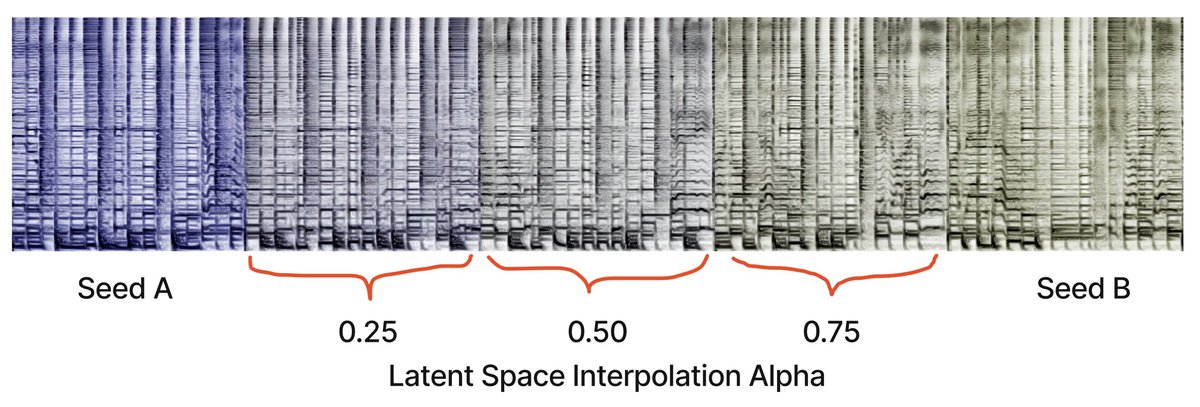

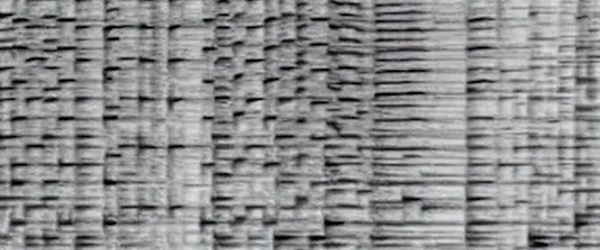

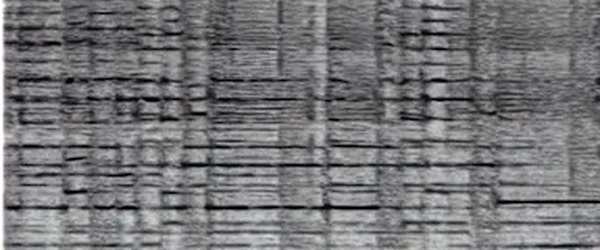

Вернее, не писать, а рисовать. Разработчики взяли Stable Diffusion 1.5 и дополнительно обучили ее на изображениях спектрограмм; теперь нейросеть может рисовать спектрограммы, транслируемые в неплохую музыку.

Вот несколько примеров музыки, сгенерированной самими разработчиками: раз, два, три.

Как и прежде, для генерации музыки достаточно задать текстовое описание: например, саксофонное соло в стиле джаз или праздничный лоу-фай бит. Попросить ИИ сгенерировать русский рэп тоже можно, в треке даже будет звучать неразборчивый вокал.

Треки, сгенерированные ИИ, могут зацикливаться и плавно сменять друг друга. Разработчики добились этого эффекта благодаря интерполяции и сглаживанию границ между спектрограммами.

Поэкспериментировать с нейромузыкой можно здесь, исходники проекта опубликованы здесь.